くまりゅう日記

2024-10-08

日記

特に何もない。

暑くて死にそうになった次の日は寒いとかひどいことになってる。まあ寒いのはいいや。 また気温も上がりそうな予報ではあるが、さすがにそろそろ最低気温が20℃切るようになってきて暑いってほどではなくなりそうか。 最低気温が下がらんと通勤する朝晩が涼しくならねえんだ。

今週末はホビーショーなので涼しいといいけど予報では最高気温はそこそこありそうだ。といってもビッグサイトは家から近いし、ちょっとくらい暑くてもそんなしんどいことにはならんだろが。

土曜日はなんかめちゃくちゃ寝てた。まず起きたのが14時頃でその後だらだらしてたら20時に眠くなったので一旦横になったら4時に目が覚めた。そのままもう一回寝たら起きたのは11時過ぎ。 日曜は寝すぎでちょっとしんどかったが家事もしたし買い物も行けたしプラモも組めたので元気になったようだ。

なんかチームでお前が一番残業多いぞって言われたので頑張って控えめにしよう。

[ゲーム] オトシューDX皆伝達成

ずっとちまちま進めていたオトシューDXがこないだついに皆伝なった。

記憶が確かなら2020年10月頃からやってたと思うのでちょうど4年かかったはず。 ゲーム下手くそだけどやってればできるもんだねえ。

目標が達成なってしまったがオトシューDX自体は面白いしまだまだ伸ばせるところはあるのでまだ遊んでいきたい。

オトシューは音ゲーが途中でぶちこまれるというところはまあ置いとくとして、メインのゲーム外を音ゲーのフォーマットに載せたSTGという、ちゃんと現代になったSTGで非常に素晴しい。 難しいとは思うが続編出てほしいねえ。いや本当に難しいだろうが……。

せめてこのフォーマットを継承した(いや音ゲーパートはなくてもいいが)他のSTGが出てくれればうれしいが、みんないまだに昔ながらのゼビウスの続編しか作らないのが哀しいところだ。

2024-10-01

日記

結構涼しくなってきたかも。 しかし涼しいと思って会社行くと汗だくになったり、それと同じくらいの暑さの日でも全然汗かかなかったり謎だ。

9月の21~23日は三連休だが疲れてほぼなんもできなかった。 いやイベントがあったので何も出さないのもアレだなということでプラモ写真撮って載せるくらいはやった。 まあ作ったやつ全部は撮れなかったので近いうちに撮っておきたいが。V.F.G.は変形が大変なので写真撮るのがだいぶおっくうになってしまう。 そろそろプラモだけじゃなくてちゃんとプログラム書きたいよ~。時間がないよ~。

仕事は一時期落ち着いた気がしたんだけどそんなことなかったぜ。熱出して休んだのもあってこないだの日曜日も出社したり。しかし毎日平均で4つ以上入っている打ち合わせとひっきりなしに点滅するSlackが無いので休日出勤はめちゃくちゃ仕事ができるのが良い。

そんな仕事やばいとか言いながら今日は休みにして名古屋まで陰陽座のライブ行った。 仕事詰まってるのに休んで遊び行くのは気がひけたんだが、今日はそれほんとにいるのかよ的な打ち合わせがめちゃくちゃいっぱい入ってる日で、どっちにしろ作業が進まないのですっぽかしても大したことがないのであった。 なんならもう一日休みにして一泊したくもあったがそこまで休むのはまずそうだったので日帰りで。

ライブは夕方からなのでそんな早く行く気もなかったんだが、新幹線取ろうとしたら日帰りツアーだと結構安くなって、しかし行きで取れるのがだいぶ早い時間帯のみ。 9時発10時半着のが一番遅かったのでそれにしといた。帰りは遅い時間も取れるようになってたので余裕見て21時20分頃。21時前には待ち合い室に居たのでちょうどいいくらいじゃないでしょうか。 陰陽座のライブ昔は3.5時間とかやってたけど、さすがにもう2.5時間くらいで終わるからね。

午前中から名古屋の街中をぶらつくはめになってしかも暑い予報だからだいぶ汗だくになりそう……と覚悟していったものの、 確かに気温は高いし日射しもそこそこ強いが、湿度が低くて涼しい風が吹いてくるので直射日光さえ避ければ涼しく感じるくらいでよかった。 あとZepp Nagoyaから歩いていける距離に山王温泉というスーパー銭湯があったので、ライブ前にそこでお風呂&着替えできたのがうれしい。

ライブは珍しく全席指定だったので座って待てるし早く入る必要も全くないので楽ちん。 席あるし荷物ロッカーに入れなくてもいいか?と思って入れなかったが、着替えとかもあってそこそこ嵩張る荷物で少し邪魔だったので素直に入れときゃよかったね。

今回はライブでは珍しい曲が多くてびっくりした。それもあってかみんなおとなしかったな。いや陰陽座のライブみんな最初はおとなしいんだけども、今回は終盤近くまでおとなしかった。 妖精帝國だと最初からぶっちぎってる人多いからむしろ避けてないと危険なくらいなのにな。

しかし楽しくて一瞬で終わるな~。東京もチケット取ってるのでまた行けるけども。さすがにその頃には仕事落ち着いてると願いたい。 まあZepp Hanedaは16時くらいに会社出れば着けるのでそれまで働くのも可能だが。

2024-09-20

日記

全然涼しくならないっすね。

先週あたりからなんかいまいち体調がよくないなと思ってたが、そんな中の三連休にはしゃぎまくって無事撃沈。 月曜夜から熱出して火曜日休んだ。熱だけだったし一日寝てたらだいたい治ったが。いや水曜も出社はしたもののあまり元気とは言えん状況だったか。

[模型] V.F.G. VB-6 ケーニッヒモンスター 一応完成とした

女の子の仕上げと機体組み上げを行ってひとまず完成とした。ひとまずってのはあちこちパーツを折っちゃってまだ修理してないので。まあそこまで目立つところではないからおおまかには完成ということでね。

最初のパチ組み開始から3.5ヶ月くらいかけてたらしい。うええ時間かけすぎだあ……。

機体は金色およびシールだったところだけ塗り、あとは全体的にテカテカにしたくらい。 女の子は胸と太股を盛って全体的に色が地味っぽいのを明るめに塗り直した、ということで手を入れたところ自体は女の子の方が多く見えるんだけども、機体のボリュームがボリュームなのでテカテカにするのが非常に大変だった。テカテカにする作業自体も初めてだったし……。

ほとんど成形色のままテカテカにしたらプラスチック感強くなってしまったのでクリアー吹く前に軽くパールを吹いてみたが、金属感とまではいかずともいくらか高級感出たのでよかった。ボリュームに見当った重さもあるので手に持つとプラモ感はなく、お値段する完成品おもちゃくらいの感じはするのでまあ悪くないんじゃないでしょうか。

しかしシャトルモードで写真撮るのにスタンドで浮かせようとしたが、下部に3mm穴が一つ開いてるだけでさすがにそれで支えるのは無理があって断念した。あとから考えたら3mmの薄いピンも出てるのでアーム2本使えばなんとかできたんか?2本すぐには用意できなかったけどさ。

ケーニッヒモンスターは特にでかくて重いというのはあるんだけども、そうでなくともV.F.G.はガンプラでいう1/100サイズくらいはあって重さもそこそこあるのに、スタンド用の穴がいつも3mm穴1つしか無いのが納得いかん。しかも飛行機だから角度つけて飾りたくなるのに3mm軸1本だと容易に回転しちゃうんだよな。 5mmの六角軸とかつけられるスタンド用パーツつけてくれればうっかりアクションベースとか挿さってうれしいんだが……。

次の連休にはなんとか修理とちゃんと写真撮りまでやっておきたいところ。あとで変形とか絶対めんどくさくてやらんからな。

2024-09-03

日記

仕事が落ち着いたかもしれん。 いやまだいっぱい働いてるけども、今週からは早く帰っても大丈夫かも。

雨の降り方がやばくて洗濯がしづらい。 急にめっちゃ荒れて10分で止むとかが1時間おきに襲ってくると洗濯物干せないし外に出る気もおきないしでなかなか困るなあ。

[模型] V.F.G. VB-6 ケーニッヒモンスター そろそろ仕上げか

機体にパールとクリアーを吹いた。

パールは真っ白にならないかなーザラザラにならないかなー?と不安なところはあったものの、どちらも問題なさそうだった。軽く吹いただけなので当然ではあるが真っ白にはならず、それでいてキラッとしてくれたのでプラスチック感は減らせたかな。この写真だとあんまわからんけども。

クリアーが自信なかったんだけども今回は上手くいったっぽい。アクリジョンのクリアーを若干薄めで重ねていき、最後は低圧で少し厚めに吹くという感じで上手くいった。 いつも圧高めで濃いめのを吹いてたのがよくなかったかもしれない。まあいつもはファレホのメカカラーバーニッシュなので塗料自体違うんだけども。 腕の平面部分とかいくらか荒いところはあるけど磨けばいい感じになりそうかな。

しかし機体一通り塗るのに新品のクリアーを1本使いきってしまった。ちょっと吹きすぎ感はあるけども、面積も結構あるから仕方ないか?そんな高いもんじゃないしな。 ファレホのメカカラーバーニッシュでも綺麗に塗れるように試行錯誤しておきたい。 メカカラーバーニッシュは固まるの遅いから磨くのには向いてないが普通に塗って終わりの時には使いたいし。

下地もだいたいピカピカにしてたのは効いたんだろうか。でも1500番くらいでざっと荒らしてクリアー吹いて磨くて話も聞くからあんま関係ない気もするんだよな。

最終的に磨くのもこれたぶんMr.ラプロスの6000番とか8000番でざっと磨いたあとコンパウンドの細目や仕上げ目でさくっと磨けばいいんだよな。 あんまり頑張らなくてもよくなりそうで希望が見えてきた。

残りは女の子の方を仕上げるのと磨くのくらいかな。さすがにそろそろ完成させられそうだ。 作業サボってた週もあるからだけどだいぶかかったなあ。

2024-08-20

日記

先週は盆休みだったので働いていた。だったので?

会社行ってちょくちょく熱中症になったり帰省してトコジラミに喰われまくったりした。

9月、いや10月にはきっと仕事もいくらか落ち着くはず。落ち着くといいなあ。

[模型] V.F.G. VB-6 ケーニッヒモンスター 機体の磨き

機体を磨いていた。

どこからどこまでやったもんかなあといろいろ試しつつやったが、Mr.ラプロス4000番もしくは神ヤス磨2000番 → ラプロス6000~8000番 → タミヤコンパウンド荒目 → タミヤコンパウンド細目てあたりが綺麗になるかなあという感じ。まあMr.ラプロスの6000・8000番は省略してもよさげに思えた。 仕上げ目は試したがほとんど違いがわからんのでやるなら本当に最後だな。このあともう一回クリアー吹きたいし。

全面的に綺麗にピカピカにできたとは言えないが、まあまあピカピカっぽい雰囲気なんでこんなもんじゃないでしょうか。まだボディが磨けてないのでもうちょいかかるけど。 削り過ぎでクリアーは全部落ちてんじゃねえかという気もしなくもないが、まあエッジ以外はきっと生き残ってんだろうきっと。エッジの辺りは金色が剥げたりデカールが剥げたりしたので怪しい。

いくらか剥げたのを直したいのもあるが、磨いてもピカピカのプラスチックにしか見えないのはちょっと気になった。まあ塗装してないのでピカピカのプラスチックなんですけどね。 すこし金属感ほしいがどうしよう。軽くパールを乗せたらいくらかよくなるかなあと思ってる。緑パールか?と思ったけどFGパールの緑持ってないしVGパールだとだいぶ派手になりそう。というか緑下地に緑パールは見えないかもか?普通に白パールでいいんかな。なんかピカピカ感は減りそうなのがこわい。

さらにそのあともう一回クリアーを吹くらしいんだが、そこでまた柚子肌になりそうな予感しかしないのが怖い。ちょっといろいろ練習しながらやらないとあぶなそうだ。 まだ時間かかりそうだなあ……。

2024-08-02

日記

暑すぎて危険だけど8月になって急に若干緩和された。また暑くならないとも限らんが。

週末はなんか疲れて死んでたけども日曜にワンフェス行ってさらに死んだ。暑すぎて無理。午後入場で並んだのも30分くらいだったんだがそれだけでもうやべえなと思ったし、中も暑いってほどではないが決して涼しくはないくらいで歩きまわる元気は出ない。なんだかんだ2時間も居たみたいだが、企業ブースを一通り見て一般はちょろっと歩いたくらいで諦めて退散した。歩いてまわるにも歩いてるだけでろくに見てもなかったし……。 帰ってから若干頭痛いなーになってた。まあちょっとで済んだけども。

月曜も強制有給消化休みで、マイナンバーカードの電子署名更新があったので役所に行ってきた。いくらか時間かかるのかと思ったが5分で終わったわ。 しかし帰りがまた大変。役所は昼間しかやってないしめちゃくちゃ晴れててめちゃくちゃ暑い。歩いて30分やそこらなんだけども……。 途中で本屋とか図書館寄って頑張って帰ってきたんだが、家出てから2時間も経ってないのにすごい出掛けてきた感あったわ。夏はもう外出できないよ……。

[模型] V.F.G. VB-6 ケーニッヒモンスター 女の子の調整

機体の磨きはトップコートがまだしっかり乾いてない感じあったのでまた今度。 ファレホのメカカラーバーニッシュは固まるまで時間かかるとわかってはいたが、一週間経ってもまだ若干ペタペタする感じあって削るのは不安あるわね。 最終的に組むだけならまあいいかと言えるくらいではあるんだけども。 トップコートとしてはよくても途中で吹くクリアとしてはやっぱり不適かねえ。 ラッカーのスプレー買っておこうか。

女の子側の調整をしてた。胸を削ったりふとももの凹みを直したり。 胸は削ってみたり削りすぎたなと思ってまた盛ったりまた削ったりでよくわからなくなってしまった。まあなんかこんなもんでいいんじゃねえかなくらいにはなったからいいか。 ふとももは凹むを埋めたりしたものの、綺麗に埋めきれなかったので軽く色塗ってごまかすことに。微妙ではあるがまあまあごまかせたんじゃないでしょうか。

肌色はVICカラーの肌色セットが安くなってたの買っておいたんだよなあと出してきてみたが、結構赤っぽい肌色しか入ってねえ。 30MSカラーの肌色でいいか、と思ったらカラーAでもだいぶ白い。もうちょい黄色っぽいのがいいなあと思うんだが。 結局VICカラーのライトフレッシュ2あたりで満足しておいたが、よく考えたらアクリジョンの薄茶色も試せばよかったな。まあいいか。

VICカラーは初めて使ったがにおい全然無いのな。あとで調べたら有機溶剤を含まないようで、じゃあ素のアクリル絵の具みたいなもんだな。そりゃにおいはないか。

あと胸の服部分をはみ出た接着剤を削って色塗り直したが失敗して2回程塗り直してしまった。しかしそのあとまた傷つけちゃったのでまた塗り直さないとなあ。雑だ。

まあだいたいこんなもんでいいんじゃないでしょうか。スミ入れと髪の塗りはやるけども。 耳とか想定よりピンクにしちゃったけどまあいいか。

2024-07-24

日記

暑すぎて危険。 9時時点で暑さ指数が危険になるのはもう困ったなと。8時に出社すればまだマシっぽいけどもそれだと14時間勤務になっちゃうのはしんどすぎない?帰る時間はどうせ変わらんので……。

先週金曜日は会社のPCがブルースクリーンループで起動しなくなり、ちょっとやそっとでなんとかなりそうな気配もなかったので早々と帰った。 せっかく平日の早い時間なのでゲーセンでも行くか~と出てみたが15時くらいで死ぬ程暑い時間帯だったので汗だくで全身びしょぬれになってしまった。 もう昼間出歩くの不可能では?

土日はほぼ家でおとなしくしてた。髪切りに行きたいな~と思っても日が落ちるころまで出られねえし。

なお会社のPCは月曜日にセーフモードからせっせと復旧した。世界中でこれが起きたのは大変だ。

[模型] V.F.G. VB-6 ケーニッヒモンスター 光沢トップコート

土曜日には機体のスミ入れを終わらせてデカールも貼った。

デカールは白い色分けが主なんだが、これ塗った方が楽じゃね?みたいなちょっと貼りづらいデカールもあって時間かかってしまった。 変に隙間できちゃったところとか欠けちゃったところは筆でレタッチしましょう。

塗った方が楽かと思われるようなデカールはカッティングプロッターとかでマスキングテープ作って塗れるとよさげだな~といつも思うんだけども、カッティングプロッター買う踏ん切りがつかない。 値段は最近は高くなってるものの2万~3万円台とまだ買えない値段でもないんだが置き場所は必要だしそんなに使わなかったらなんだなーと。

機体は光沢テカテカに磨きたいなとも思ったのでグロスのトップコートを吹くことに。 アクリジョンのクリアーとファレホのメカカラーバーニッシュどっち使おうかなあと悩んだが、面積でかいのでメカカラーバーニッシュでいいか。 アクリジョンのクリアーの方が乾燥は確実に早いんだが、まあ一週間はあけるので大丈夫でしょう。

いつもはプロスプレーでばーっと吹いちゃうんだけども、ちゃんとおとなしく吹きたいのでエアブラシでやってみたらまあ詰まること詰まること。 プロスプレーでも詰まるんだけどもエアブラシでもだめかー。 二周ほど吹いたところで全く詰まりが解消できなくなったので諦めてプロスプレーを使った。 あとでノズル外して掃除したらかたまりが出てきたので、そりゃ詰まりも解消できませんわね。 プロスプレーも詰まりまくるんだけども、こいつはノズル剥き出しだしニードルもないしですぐ掃除できるので復帰は早い。

毎度詰まりまくるのにキレながら吹いてるけどやっぱりメカカラーバーニッシュは諦めた方が楽なんだろうか?でも値段が格段に安いんだよなあ。 水性ホビーカラーとかだと10mlで200円弱はしちゃうけど、メカカラーバーニッシュは200mlで1500円で済むのはでかい。10ml毎の瓶を処分するのもめんどくさいし。 しかしめちゃくちゃ詰まってめんどくさい。うーん。

で思ったんだけども、詰まりまくるのはもしかしたらアクリジョンの薄め液を使ってるのが悪いのかもしんない。ファレホの薄め液をちゃんと使った方がいいんでは……。 いや乾燥速すぎるのが問題なら水で薄めた方がいいのかもしんない。まあちゃんと固まるまでは遅いんだけども、それは水でも薄め液でもそんなに変わらなそうだし。

ちょっと薄め液変えていろいろ試してみるか。まあボトルから出す時点で塊が出てきたりもするんであんまり関係ないかもだけども。

2024-07-19

日記

水が出ておなかが痛くなった。

水は先週日記書いたあとに金曜日には直りそうと連絡来て、実際に金曜日の夕方には直った。 これでめでたしめでたしと言いたいところだったが、連絡来たのと前後しておなかが痛くなってしんどくなってしまった。 おなかも下してるわけではないが、なんか左上のあたりが筋肉痛みたいな痛みあるし変なので金曜日に病院行った。

どうも腸の壁が薄いところ周りで炎症おこしてるっぽいとのことで採血して抗生剤もらって今日はなんも食うなと。えー。 土曜日に採血の結果聞きにいって、結構しっかり炎症反応出てるので今日も食うな、明日から素うどん生活1ね、と言われてしまった。 最後に食ったの木曜の昼なんですが……。まあゼリーとかは飲んでもいいっていうのでそれで気を紛らわした。

結局しばらく素うどん生活してだいぶ良くなって、昨日も病院行ってよくなってるので今週いっぱい素うどん生活したら無理しない範囲で戻して良いと。やったー。 まあさすがに飽きたので今週いっぱいなんて待てねえがな!とさっそくおにぎり食べてしまったが、海苔もついてないやつなので許して……。

なんか踏んだり蹴ったりだなあ。まあ仕事でいっぱいいっぱいだったところに断水が重なってストレスとかでやられたのかもしれん。まだ仕事は忙しいですけども。9月か10月くらいになれば少しは……。

-

素うどんだけではないんだが、素うどんと素蕎麦とお粥と卵と豆腐くらいしか食えない。 ↩

[模型] V.F.G. VB-6 ケーニッヒモンスター 盛ったり

おなかが痛くなったりはしてたけど、家でおとなしく作業してる分には大して問題なかったので模型作業はそれなりに進んだ。 水も出るようになってたしね。

機体の方は部分塗装も終わらせて、あとスミ入れがもうちょい、1/4くらい残ったかなというところ。

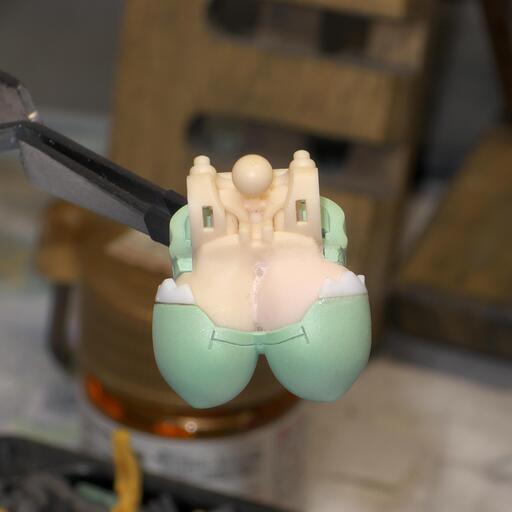

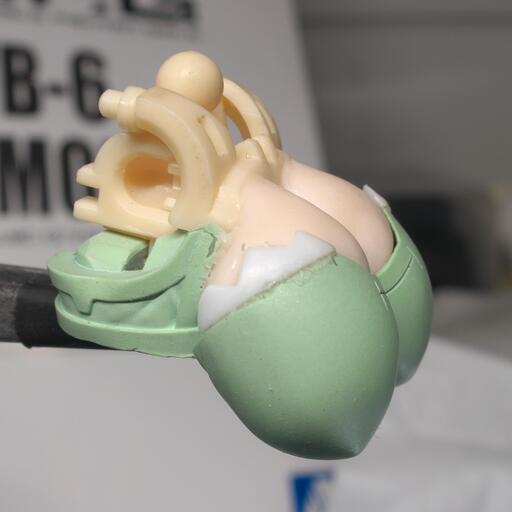

女の子側の気になってたところを修正したい。胸がよお。 女の子は胸がでっかいんだけども、胸の服パーツの厚みが結構あるのでイラストなんかとは若干印象が違っている。うーんもっとでかい感ほしいよね。 服を削って薄くすればいいんだけど、外形を削るのは大変すぎるので、内側を削ってその分肌色側を盛ってでっかくしちゃうか。 ただ胸パーツの服部分は若干ながら上下に向きを変えて垂れ方向が変わるという頭のおかしいギミックが入っているのでそれを残しつつ盛るのは難しいかも……。

まあでもやってみないとわからんよねということでやったのがこちら。

左胸(向かって右)のみ盛ったもの。この写真だとわかりづらいが……。服の外形は全くいじらずに内側だけ削って特に縁を薄くしてできた隙間に肌色を盛った。盛りすぎたかもしんない。

最終的には両方やった。可動する限界まで盛ってみた。

うおでっか……。前に垂れた(?)状態ではこんなもんな感じするけども、下に垂れた状態ではでかすぎに見えるなあ。あとでもうちょい削るかも。 いずれにせよ服が厚すぎるのは解決できた感じだ。前から見るとあんまりかわらないんだけどちょっと横から見ると厚みが気になったもんな。 なお盛ってる間にはちきれて可動部のピンが折れたので真鍮線で置き換えた。でかすぎたぜ。

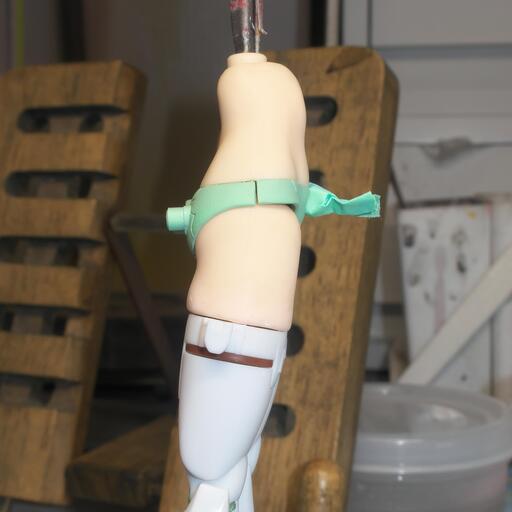

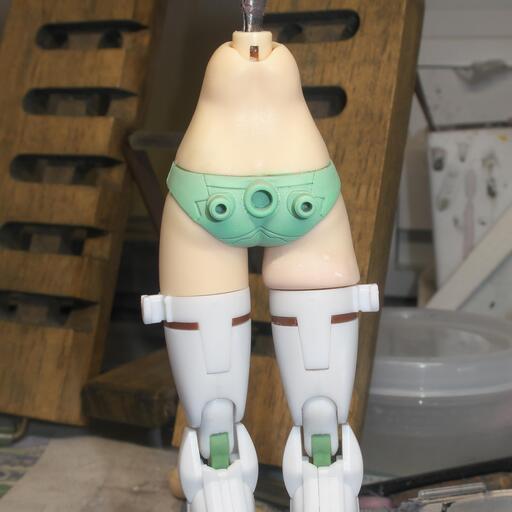

胸はとりあえず盛ったんだが、今度はふとももも気になる。V.F.G.の女の子はふとももがスッとほぼ直線になってて、まあスーツみたいなのだとそれでいいんだけども、この子はふともも肌色でニーハイソックスみたいに途中から白になってて、それがほぼ直線でつながってるのは違和感あるんだよな。胸でかいのになんで下半身だけそんなスッとしてんだよと。ということで盛ってみた。

右脚(向かって左)のみ盛ったもの。ちゃんと肉感が出ましたね。ちょいと盛りすぎな気がしなくもないが、まあ胸でかいしいいか!

これも両方やりました。

腰から下だけで見ると両方やった時点でだいぶ盛りすぎた感あったんだけど、だいたい組み上げるとそこまで目立つわけじゃないんでまあこんなでもいいかなってなった。 むしろ胸がやっぱ盛りすぎなのでもうちょっと削りたいっすね。 こうなるとおなかもちょっと盛った方が?とか思いもしたが、キリないのとおなかは気になるところがあったわけじゃないのでこのままにしときましょう。

肌色の瞬着パテで盛ったんだけどほとんど違和感ない色でできたのは助かるな。胸は盛りすぎたこともあって結構周りと色違うんだが、ぱっと見はわからんね。しかし穴は結構あいちゃってて、埋めたところに削りかすが残ったまま埋めちゃって白くなったところとかもあって綺麗にするのが大変。やっぱり最終的には肌色塗装しないとだめかもしんない。

機体の方は磨いてテカテカにしたいと思ってて時間かかりそうだし、女の子の方ももう少し時間かかってもいいので頑張って綺麗に仕上げるか。

ところでこないだリューターのアルティマATを買っておいたんですが、初めて使ったのが女の子の胸パーツを削るのになってしまった。あとSSRビットも買ってたんだけどやっぱり女の子の胸パーツを削るのが最初になった。 ま、まあ、髪の毛パーツを削るのに便利だなと思った買ったんでそれが盛った胸になったところで大して違いはないか……。

2024-07-11

日記

水が出なくなった……。

月曜の夜に洗濯してたら洗濯機がエラーで止まって蛇口が閉まってんぞと。いやいや最初ならまだしも途中で蛇口止まるわけねえだろと思ったら水が出なくなっていた。 深夜だしどうしようもないが、幸いすすぎ2回目で止まったところだったのでまあ1回は終わってるからいいやとそのまま脱水して干しといた。 朝管理会社に連絡しといたら夜返事が来ててポンプ故障とのこと。あらら長引くかな?と思ったら次の日にはポンプ発注したんで直りそうな時期がわかったら連絡しますとのこと。 修理とかじゃなくて交換なのか。長引きそう……。

水出ないのは困るんだが、最近ずっと会社に居るので意外とそれほどでもなかった。お風呂と洗濯くらいか特に困るのは。 洗濯はコインランドリーで済ませて、お風呂は銭湯行くしかねえな。 ただ銭湯はそんなに遅くまでやってないが、家に帰るの22時半なんですよ。 幸い歩いて10分ちょいの銭湯が23時半までやってるので間に合いそうだ。 まあ電車乗ってちょっと遠くのスーパー銭湯まで行く手もあるが、さすがに毎日行くには高いか。

しかし会社行ってから着替えるようにしたおかげで早めに出社してんだが、それに加えて銭湯行ったりコインランドリー行ったりでめちゃくちゃ時間ねえ。 すぐ直してくれるだろうからホテルとか泊まるのは逆にめんどくせえなと思ってたけど、長引きそうならホテル住まいも考えた方がよさそうだ。どうせ平日は会社行くしかできねえし。 とりあえず週末まで様子見て、来週だめそうならホテル取ろう。

[模型] V.F.G. VB-6 ケーニッヒモンスター 一部塗装

土曜日は本読んでたら作業できなかったので日曜にちょっくら筆塗りしたくらい。

黒の部分をちょっくら筆塗りしただけなので何も面白いことはありません。 女の子側の金と、機体側の赤がまだ塗れてない。黒塗るだけでずいぶん時間かけちゃったな。といっても始めるの遅くて3時間くらいだったけども。

今度の週末でトップコートまで吹けそうとか言ってたけど、断水してるからどうかなあ。 いや作業自体はそんな大量に水使うわけでもないが、家に居ないかも?

2024-07-03

日記

曇ってるとまだいいけど晴れるとめちゃくちゃ暑い季節になって大変。 昨日はなにげにいつも通り出社したら汗で服がびっしょびしょになって会社の中は冷房で冷やされまくって凍えそうだしで死ぬかと思った。 今日は着替え一式持って出社して、着いてすぐトイレに籠って着替え。しかし着いてしばらくは汗が吹き出るからすぐ着替えるのはいまいちうれしくない。 でも遅くなるとトイレ混むからある程度落ち着いてから着替えるのも難しい。 早く出社するしかないかー?しんどい。

ほんと夏の出社は悪だよ。真夏にも出社必須とか悪の企業だよ。

こないだの土曜日は17時間くらい寝てた気がする。そしたら日曜からに頭痛くなってしまった。寝過ぎかもしれないしそうでもないかもしれない。 まあいつもどおり家事と模型作業しかしてないが。プログラムも書きたいのに元気と気力がない。

[模型] V.F.G. VB-6 ケーニッヒモンスター 金色塗りなど

金色の部分の下地を磨く作業は永遠に続くかと思いきや意外とすんなり進んだ。

タミヤのコンパウンドの荒目は言う程荒くもない感じ。#4000と#6000のMr.ラプロスあるいは#2000と#4000の神ヤスで削ったあとに荒目でちょうどいいかなあという雰囲気だった。 そのうえで細目を使うとだいぶピカピカに。仕上げ目までやるともっとピカピカするのかもしれないけど下地なのでそこまではいらないだろう。

コンパウンドの前もちょっとめんどくせえので#2000の神ヤスを電動歯ブラシにくっつけて磨くのはやべえかなあと思いつつやってみたら全然やばくなかった。 むしろ手でやるより速いし結果的に剥げも少なく削れそう。#4000まで電動歯ブラシでやって、コンパウンドの荒目→細目がいい感じね。

日曜には一通り磨き終えたのでそのままこすって銀Sunをこすりつけた。まあやっぱり全部ピカピカとは言えないか。本当にピカピカにするならもっと気をつけて磨かないとだめっぽい。難しいなあ。 今回は諦めるけども。

一通り銀色にした時点で0時だったのでもう寝るべきだったが、馬鹿なので我慢できずに塗装まで始めてしまった。 クリアオレンジとクリアイエローを混ぜて上からキャンディ塗装。 そんな難しいところもなくいい感じにできたんじゃないでしょうか。

ある程度乾いて様子を見たところ、それなりに金色ではあるけどもやっぱり曇っちゃってメッキのようにピッカピカとは言えねえな。まあそれは覚悟の上なんで仕方ない。 あと光の反射がないと暗めになってしまうのはちょい気になる。地味かも……と心配はしたけどもマスキング剥がしてみたらそれなりに派手だったので大丈夫そうでよかった。

次はスミ入れ、部分塗装、デカール貼りかな。トップコート吹いたら全体を磨いてもみたいけど、時間かかりそうでどうだろう……。